- Интервью

- Отчеты о конференциях

- Цифровая трансформация

- Электронный документооборот

- Финансы: стратегия и тактика

- Общие центры обслуживания

- Информационные технологии

- Финансовая отчетность

- Риск-менеджмент

- Технологии управления

- Банки и страхование

- Кадровый рынок и управление персоналом

- Управление знаниями

- White Papers

- Финансы и государство

- CFO-прогноз

- Карьера и дети

- CFO Style

- Советы по выступлению на конференциях

- Обзоры деловых книг и журналов

- История финансов

- Свободное время

- Цитаты

КОНФЕРЕНЦИИ

Все

Все

-

24 января 2025 года

Москва -

7 февраля 2025 года

Москва -

13 февраля 2025 года

Москва -

14 февраля 2025 года

Москва -

19 февраля 2025 года

Москва -

13-14 марта 2025 года

Москва

Татьяна Курганович, Банк ВТБ: «Шансы, что LLM-модели станут автономными и смогут работать без поддержки человека, есть»

26.12.2024

Справка о компании: Банк ВТБ – системообразующий универсальный российский банк, один из лидеров рынка финансовых услуг. Банк работает со всеми категориями клиентов – крупным, средним и малым бизнесом, индивидуальными предпринимателями, самозанятыми и физическими лицами.

Что такое LLM?

Large Language Model (пер. – большая языковая модель) – это тип искусственного интеллекта, предназначенный для работы с естественными языками и текстами. Он способен выполнять различные задачи, такие как перевод, обобщение информации, ответы на вопросы и создание текстов на основе заданного контекста.

Технически LLM представляет собой сложную нейронную сеть с миллиардами параметров, которая, используя алгоритмы машинного обучения, обрабатывает языковые структуры.

Вне зависимости от того, какое определение мы им даем, основная функция этих моделей заключается в работе с языками и речью.

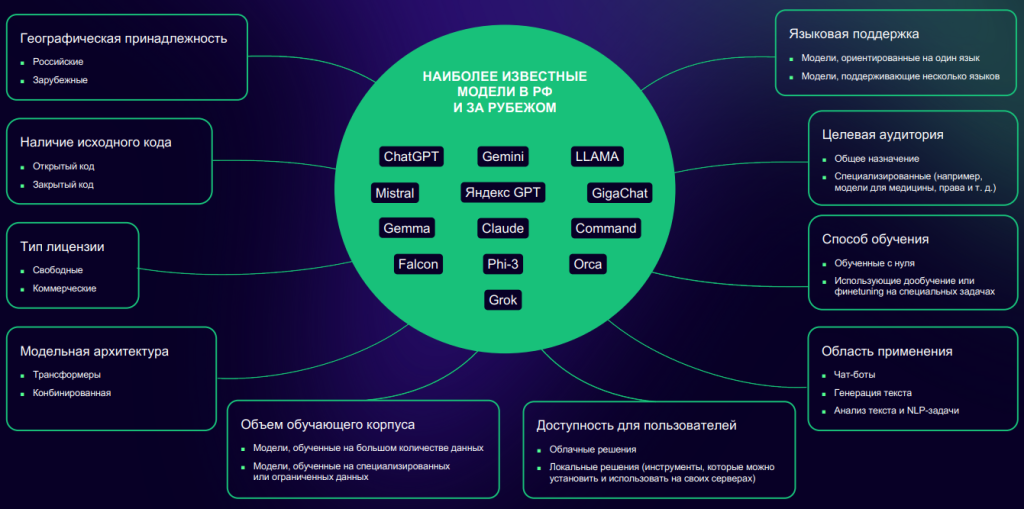

Существует множество моделей, которые можно классифицировать по различным критериям, таким как страна происхождения, язык обучения, тематика и отраслевая принадлежность. Такое разнообразие вызывает множество вопросов, создаёт шумиху и возлагает большие надежды на эти решения.

Например, в банковском секторе клиенты ожидают, что LLM-модель сможет понять их речь на любом языке, определить их потребности, предложить оптимальное решение, уточнить недостающую информацию, быстро подготовить понятный ответ и сформировать его оптимальный дизайн с учетом устройства, с которого человек обращается. Также ожидается, что модель должна уметь синтезировать голосовые ответы с заботой и эмпатией. Кроме того, обеспечивать безопасность и соответствовать политике конкретного банка и требованиям законодательства Российской Федерации. Для наглядности все эти требования представлены на слайде ниже:

То есть от LLM-модели ожидают, что она станет неким магическим решением. Верю ли я в эту магию? Да, когда-нибудь обязательно так и будет. Но сперва посмотрим на исследования, которые мы провели в ВТБ, чтобы понять, с чем мы сталкиваемся на практике, работая с LLM.

Какими пилотами мы проверяли возможности LLM?

Во-первых, мы создали сервис для консультирования клиентов по тарифам продуктов и услуг банка. Учитывая разнообразие продуктов и услуг, мы выбрали для эксперимента информацию, доступную на сайте банка, включая информацию о картах, расчётном счёте, ипотеке, автокредитах и депозитах. Затем мы проверили, насколько хорошо модель отвечает на вопросы клиентов по этим темам.

Во-вторых, мы провели пилотный проект под названием «Интеллектуальный анализ телефонных разговоров с клиентами». Мы предоставили LLM-модели более 35 тысяч реальных обезличенных диалогов между клиентами и банком и попросили её составить краткое резюме каждого диалога и определить, был вопрос клиента решён или нет. Если вопрос не был решён, модель должна была определить причины и предложить возможные решения. Таким образом, генеральная выборка составила 35 тысяч диалогов, из которых 2 тысячи были в разметке.

По каким критериям мы выбирали LLM для пилотов?

Поскольку мы соблюдаем все законодательные требования и работаем в рамках российского рынка, мы используем только отечественные модели, поддерживающие русский язык и способные интегрироваться в банковскую систему. Мы также понимаем, что модели должны иметь возможность обучаться на наших данных. Кроме того, важно наличие технической поддержки, которая поможет нам в процессе пилотного проекта и обеспечит эффективное взаимодействие с моделями. Таким образом, два российских решения (назовем их LLM1 и LLM2) стали нашими основными инструментами. Эксперименты проводились в песочнице Ассоциации финансовых технологий, куда можно «пролить» свои данные и поэкспериментировать с ними, где доступны API и фреймворки, которые позволяют создавать программы для работы с моделями. Мы были не единственными участниками этого проекта, другие банки и компании также проверяли свои гипотезы, связанные с контактным центром и не только.

Какие подготовительные работы пришлось провести для старта пилотов?

Очевидно, что модель не может волшебным образом решить задачу без дополнительной подготовки. Разберем, что необходимо было выполнить для внедрения LLM в рамках сервиса консультации по тарифам наших продуктов и услуг. Большинство тарифов банка представлены в формате таблиц, поэтому первым шагом стало преобразование данных из таблиц в текстовый формат с помощью специальных инструментов.

Большие документы мы разделили на текстовые блоки размером до 2000 символов, чтобы модели было проще работать. Затем всё загрузили в песочницу. Далее требовалось разработать RAG-сервис (Retrieval Augmented Generation – генерация с дополненной выборкой). Он выполняет две функции: поиск документов или текстовых блоков, потенциально содержащих ответ на вопрос клиента, и генерация правильного ответа с использованием LLM-модели. Модель получает вопрос клиента и обрабатывает информацию, создавая ответ с учётом контекста.

Затем нужно было проверить обе составляющие RAG-сервиса на эффективность. Для оценки точности поиска документов с возможными ответами и качества генерации ответов с использованием найденных документов выбрали методику тестирования, определили, каким образом будет проводиться проверка (вручную или автоматически), и подготовили разметку для этих процессов. Если использовалась автоматическая проверка с применением LLM-моделей, необходимо было создать инструмент для контроля результатов.

Что касается работы по интеллектуальному анализу звонков, сначала мы обезличили клиентские диалоги, чтобы предотвратить утечку конфиденциальной информации. Затем выгрузили данные в песочницу АФТ и разметили часть диалогов для проверки качества работы модели. Сформировали запрос для суммаризации, определили параметры и формат ответа. Также выбрали метод проверки точности работы модели.

После первых «прогонов» на основе тестовых данных и заданий мы получили среднюю точность работы модели около 60%. Этот показатель может варьироваться в зависимости от конкретной задачи и модели. Результаты совпали с нашими ожиданиями. Мы понимали, что данная точность LLM-модели не подходит для практического применения.

Какие исследования и работы появились уже во время пилота?

Во время второго этапа пилотов мы проанализировали проблемные области и определили, что необходимо доработать и улучшить.

Для сервиса консультаций по тарифам банковских продуктов работа была сосредоточена на очистке текстовых данных от лишней информации, мы преобразовали JSON в псевдо-JSON и удалили избыточный синтаксис (точки, запятые, скобки и прочее). Затем с использованием LLM-модели создали парафразы из этих псевдо-JSON и сформировали синтетические вопросы для каждого блока текста. Эти действия были направлены на улучшение функции поиска, чтобы RAG-сервис мог эффективнее находить блоки, содержащие или потенциально содержащие ответы на запросы клиентов.

Далее мы доработали RAG-сервис для создания понятных и легко воспринимаемых ответов клиентам. После улучшения функции поиска, которая стала находить ячейки с реальными ответами, возникла проблема с генерацией односложных ответов (как модель видела в ячейке ответ, так его и переносила). Например, при запросе о возможности получения автокредита в определённой валюте, модель выдавала ответ «в рублях». Чтобы избежать предоставления информации в некорректном формате, мы снова обратились к LLM-модели и провели дополнительный «прогон», попросив её расширить и уточнить ответ. Таким образом, ответы стали более информативными и полезными.

Интересный факт: мы также исследовали оптимальное количество контекста для получения наилучшего результата. Казалось бы, если предоставить модели вопрос клиента и один фрагмент текста с верным ответом, этого будет достаточно. Однако выяснилось, что одной модели требуется три фрагмента текста, включая верный ответ, а другой модели – девять фрагментов текста, один из которых содержит верный ответ.

Что касается интеллектуального анализа звонков клиенту, в целом, по поводу суммаризации (процесса получения резюме на основе текста) вопросов не возникало. Модель справляется с задачей прямо «из коробки» и не требует значительных доработок. Единственная сложность связана с длинными диалогами: LLM иногда трудно создать краткое резюме из нескольких предложений. Поэтому мы экспериментировали с Map-reduce суммаризацией, разбивая исходный диалог на фрагменты, создавая резюме для каждого из них, а затем объединяя их в общее «мегасаммари». Эксперимент оказался успешным, и полученный инструмент работает эффективно.

Мы сосредоточились на оптимизации процесса генерации резюме, чтобы модель могла точнее определять результат разговора с клиентом. Сравнивались результаты генерации резюме в двух ситуациях: когда модель получает размеченный пример диалога (то есть, когда человек прописывает, что в диалоге было корректно, а что нет, и была ли решена проблема), и когда она работает без него. В первом случае точность классификации результатов улучшается, поскольку модель имеет дополнительную информацию для обучения. Однако ручная разметка требует времени и усилий, поэтому необходимо найти оптимальный баланс между предоставлением разметки и повышением качества работы модели.

Кроме того, мы сравнивали две методики классификации длинных диалогов. Мы предоставляли пример разметки и в первом случае просили написать резюме по всему длинному диалогу, а во втором – резюме по краткому саммари. Результаты оказались схожими. После дополнительных экспериментов и улучшений точность повысилась до 83-84%, что пока недостаточно для промышленного применения. Мы стремимся к высоким стандартам и постоянно работаем над улучшением моделей и бизнес-процессов. Хотя точность в пилоте можно было бы довести до 90% и выше, мы пока оставили текущий уровень: сначала необходимо наладить некоторые бизнес-процессы, а потом вернуться к пилоту с LLM. О них рассказываю в последнем разделе статьи.

Итоги и дальнейшие планы

В настоящее время мы сосредоточены на решении ряда задач, связанных с консультациями, продуктами и услугами. Во-первых, мы разрабатываем стратегии ответов на общие вопросы и проводим дополнительное тестирование на основе реальных вопросов клиентов. Обычно клиенты задают довольно общие вопросы, например, о том, какой вклад является наиболее выгодным, какой кредит выгоднее, что для них лучше и так далее. Эти понятия являются достаточно абстрактными, и без дополнительных уточнений на такие вопросы сложно ответить. Также клиенты интересуются, в какой валюте, регионе или территории лучше всего осуществлять вклад или брать кредит. Лучший вклад – это сохранение или накопление средств, а также есть ли дополнительные возможности для изъятия средств? Лучший кредит – это кредит на покупку какого автомобиля? В связи с этим возникает вопрос о том, как бизнесу следует отвечать на такие запросы клиентов. Возможно, предоставить им всю необходимую информацию, чтобы они самостоятельно выбрали наиболее подходящий вариант, или задать дополнительные вопросы и суммировать ответы клиентов в один общий запрос, а затем найти на него ответ. В бизнесе могут существовать различные подходы к решению этой задачи, и мы изучаем оптимальные варианты. После этого, разумеется, будет проведено дополнительное тестирование с использованием реальных вопросов клиентов.

Кроме того, мы осознаём необходимость адаптировать структуру хранения данных для улучшения поиска. В прошлом, когда компании переходили от бумажных документов к цифровым, они проходили через аналогичный процесс оцифровки. Сейчас, с появлением больших языковых моделей (LLM) и искусственного интеллекта (AI), структура хранения данных также будет меняться. Документы в форматах Word, PDF, таблицы и т.д. должны быть преобразованы в текстовый формат, разделены на смысловые блоки (чанки) и оптимизированы для исключения избыточного синтаксиса. Это обеспечит более точное соответствие запросам пользователей. Работа над этими задачами займёт некоторое время, и параллельно потребуется доработка RAG-сервисов, установка дополнительных мер контроля и оценка результатов. Важно помнить, что процесс динамичен, и постоянно происходят изменения в LLM-моделях, тарифах, продуктах и стратегиях, а также меняются запросы клиентов. Всё это взаимосвязано, и постоянный ручной контроль невозможен. Поэтому необходимо разработать систему автоматического контроля.

Интеллектуальный анализ звонков клиентов выявил ещё одну интересную особенность: модель, не имея доступа к документации по стандартам качества обслуживания, определяет решение вопроса клиента на основе tone of voice оператора и зачастую принимает сторону клиентов. Это их радует, поскольку иногда возникают спорные ситуации, когда, например, оператор говорит, что произошла авария на линии, и просит перезвонить через 10 минут. Казалось бы, оператор сделал все, что возможно, он никак информацию сейчас не получит, но вопрос клиента при этом не решен. Необходимо проанализировать эту разницу с точки зрения работы оператора и уровня удовлетворённости клиентов, а также разработать методы контроля для LLM-моделей.

Как итог отмечу, что с LLM надо работать много, и работать хорошо. Может быть, «зайца» целиком мы из шляпы не вытащили, какой-то ошеломляющей магии не случилось, но хотя бы его «уши» показались: шансы на то, что LLM-модели станут полностью автономными и смогут работать без поддержки, есть.

Татьяна Курганович, руководитель направления управления «Контактный центр» департамента клиентского обслуживания, Банк ВТБ

Наши конференции:

- Конкурс и премия «Лучшее корпоративное налоговое управление 2025»

- Вторая конференция «Управление налоговыми рисками»

- Восьмая конференция «Управление рисками в промышленности»

- Семнадцатый форум финансовых директоров розничного бизнеса Retail CFO 2025

- Четырнадцатая конференция «Кадровый ЭДО: цифровизация на практике»

Комментарии